CrossFIT: przekraczanie granic w prognozowaniu cen energii elektrycznej

Agnieszka.Rajda

śr., 29/11/2023 – 11:04

Prognozowanie cen energii elektrycznej jest gałęzią prognozowania na styku nauk ekonomicznych, statystyki, informatyki oraz elektrotechniki, która koncentruje się na przewidywaniu cen na hurtowych rynkach energii elektrycznej. Jej początki sięgają wczesnych lat 90. XX wieku, kiedy to deregulacja sektora energetycznego doprowadziła do wprowadzenia konkurencyjnych rynków w Wielkiej Brytanii i Skandynawii. Zmiany szybko się rozprzestrzeniły i obecnie w wielu krajach na całym świecie handel energią elektryczną odbywa się zgodnie z zasadami rynkowymi.

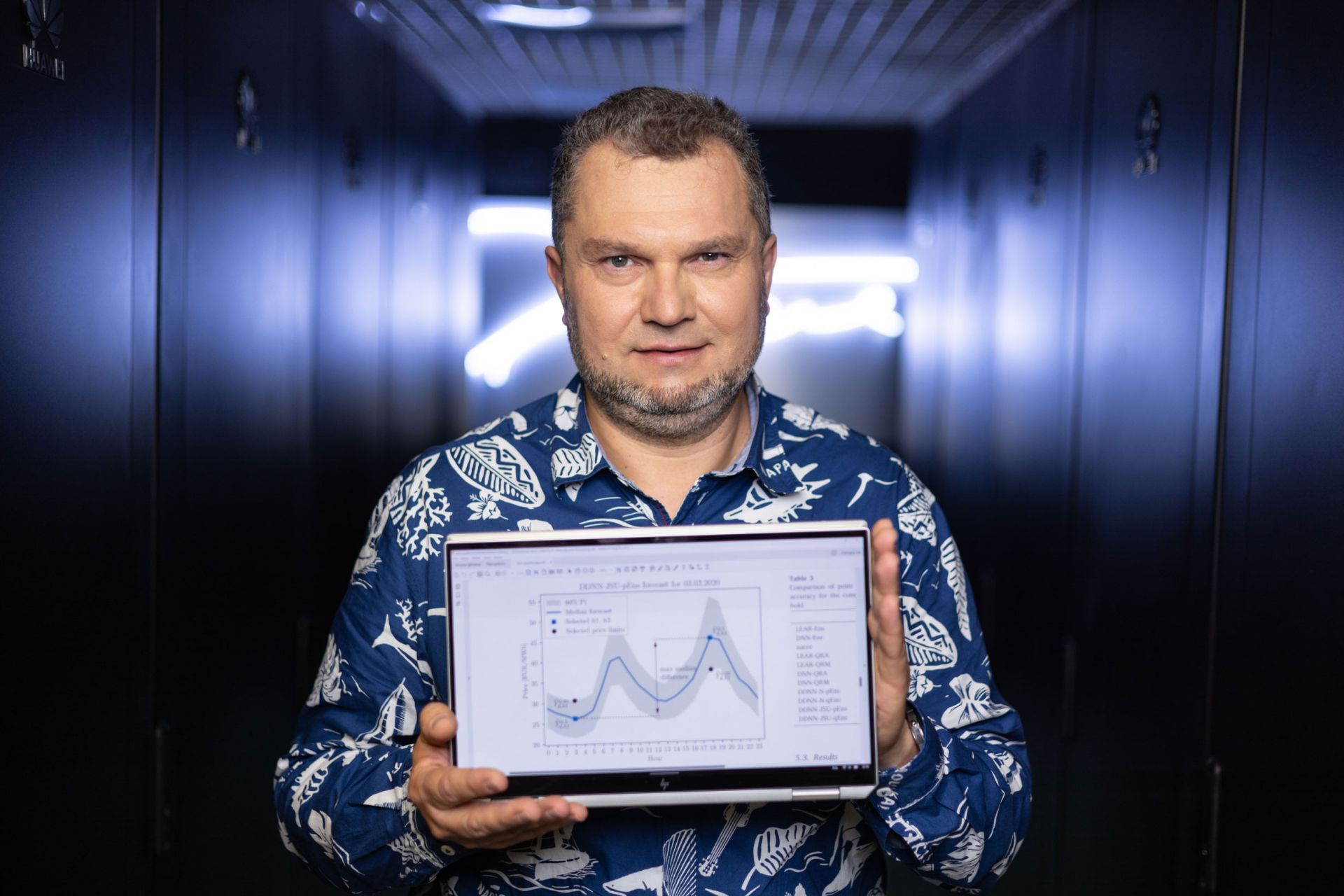

prof. Rafał Weron, fot. Michał Łepecki

prof. Rafał Weron, fot. Michał Łepecki

W ciągu ostatnich 25 lat próbowano wielu podejść do prognozowania cen energii elektrycznej. Jednak niespotykany wcześniej wzrost udziału produkcji energii ze źródeł odnawialnych i aktywne zarządzanie stroną popytową z jednej strony, a także postęp w technikach uczenia maszynowego i wzrost mocy obliczeniowej z drugiej, dostarczyły impulsu oraz – bardzo potrzebnych – technicznych możliwości przekroczenia dotychczasowych granic w prognozowaniu cen energii elektrycznej.

Celem projektu CrossFIT jest wykroczenie poza obecny stan wiedzy oraz pulę dostępnych metod i wprowadzenie prognozowania cen energii elektrycznej na nowy poziom. Badania prowadzone są w ramach współpracy międzynarodowej (Holandia, Niemcy, USA) w czterech kierunkach.

Pierwszy oparty jest na najnowszych osiągnięciach w zakresie uczenia głębokiego (ang. deep learning; tj. wykorzystania wielowarstwowych sieci neuronowych) oraz uczenia statystycznego (ang. statistical learning; np. algorytmów regularyzacji, które „karzą” za przeuczenie i faworyzują mniejsze modele) w celu opracowania modeli zdolnych do wydobywania użytecznych informacji w dobie dostępności tzw. Big Data (czyli dużych i złożonych zbiorów danych). W ramach projektu opracowaliśmy już m.in. model LQRA, który wykorzystuje metodę LASSO (ang. least absolute shrinkage and selection operator) do automatycznego wyboru zmiennych w regresji kwantylowej, a tym samym rozwiązuje problem podatności metody na niskiej jakości predyktory. We współpracy z naukowcami z Carnegie Mellon stworzyliśmy również architekturę NBEATSx umożliwiającą interpretację składowych głębokiej sieci neuronowej, co ma ogromne znaczenie dla praktycznych zastosowań i wpisuje się nurt “eXplainable AI” (XAI).

prof. Rafał Weron, fot. Michał Łepecki

prof. Rafał Weron, fot. Michał Łepecki

Drugi kierunek wykorzystuje najnowsze koncepcje uśredniania prognoz tego samego lub innych modeli estymowanych na różnych oknach danych. We współpracy z badaczami z Politechniki w Delft opracowaliśmy zestaw najlepszych praktyk i udostępniliśmy kody w Pythonie (jednym z najpopularniejszych języków programowania) dla dwóch konkurencyjnych benchmarków wykorzystujących uśrednianie, tak aby nowo proponowane w literaturze algorytmy prognostyczne mogły być rygorystycznie oceniane. Ponadto, we współpracy z naukowcami z Uniwersytetu Duisburg-Essen przetestowaliśmy nowe metody uśredniania prognoz probabilistycznych, tj. prognoz całych rozkładów.

Trzeci kierunek dotyczy prognoz trajektorii cen, w przypadku których trudność polega głównie na złożoności narzędzi ekonometrycznych potrzebnych do opracowania modeli prognostycznych i metod do oceny jakości otrzymywanych prognoz (obiektów wielowymiarowych). W ramach projektu zaproponowaliśmy metody, które z pomocą tzw. funkcji copula (wielowymiarowych dystrybuant używanych do opisu zależności między zmiennymi losowymi) pozwalają przekształcić prognozy probabilistyczne w prognozy trajektorii cen energii elektrycznej.

Wreszcie czwarty kierunek dotyczy spojrzenia na błędy prognoz z zupełnie innej perspektywy. Nacisk jest położony nie na same błędy, ale na wpływ błędów w prognozach na wyniki finansowe. Opracowane w ramach projektu uniwersalne strategie handlowe pozwalają ocenić, to co jest naprawdę ważne dla przedsiębiorstw. Udało się nam pokazać, że strategie oparte na prognozach probabilistycznych prowadzą do znacznie lepszego wyniku finansowego niż te oparte na prognozach punktowych oraz – co ciekawe – pozwalają osiągać zyski, które są bardzo zbliżone do strategii “wyroczni”, zgodnie z którą zawsze kupuje się po najniższej cenie dnia i sprzedaje po najwyższej.

Więcej informacji na temat projektu znajduje się na stronie Katedry Badań Operacyjnych i Inteligencji Biznesowej na Politechnice Wrocławskiej.

Jest profesorem nauk ekonomicznych, członkiem Academia Europaea oraz kierownikiem Katedry Badań Operacyjnych i Inteligencji Biznesowej na Politechnice Wrocławskiej. Zaliczany jest do grona światowych ekspertów w zakresie prognozowania na rynku energii.

Wprowadził do literatury oraz praktyki biznesowej metodę Quantile Regression Averaging (QRA), wykorzystaną później przez dwa zwycięskie zespoły w konkursie Global Energy Forecasting Competition 2014, oraz architekturę NBEATSx umożliwiającą interpretację składowych głębokiej sieci neuronowej prognozującej ceny energii, co zostało uznane przez magazyn Forbes w 2023 roku za jeden z pięciu najważniejszych kierunków rozwojowych Deep Tech.

Jego najważniejszym osiągnięciem jest prawdopodobnie „seria” trzech artykułów przeglądowych na temat prognozowania cen energii elektrycznej, która promuje rygorystyczne stosowanie metod, miar błędów oraz testów statystycznych. Za artykuł z 2014 roku otrzymał Emerald Citation of Excellence Award oraz nagrodę International Institute of Forecasters, a wszystkie trzy znajdują się na liście Highly Cited Papers według bazy Web of Science.

Source: NCN